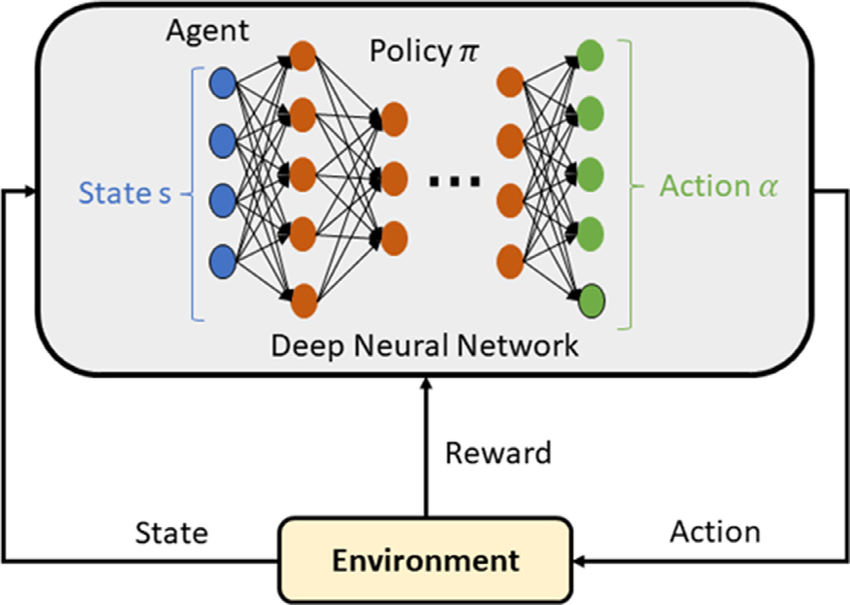

深度强化学习(Deep Reinforcement Learning, DRL)是一种结合了深度学习(Deep Learning, DL)和强化学习(Reinforcement Learning, RL)的机器学习方法。它通过使用深度神经网络来近似强化学习中的策略或价值函数,从而解决复杂的决策问题。

一、组成部分

1. 强化学习(RL):一种让智能体通过与环境的交互来学习最优行为策略的机器学习方法。它通常包括一个智能体(Agent),一个环境(Environment),一个奖励系统(Reward System),以及一个策略(Policy)。

2. 深度学习(DL):一种使用多层神经网络来学习数据的表示和抽象的机器学习模型。它能够处理大量数据,并且能够学习复杂的非线性关系。

3. 策略网络(Policy Network):在DRL中,策略网络用于预测给定状态(State)下采取的行动(Action)。它通常是一个深度神经网络,可以输出一个概率分布,表示在给定状态下采取各个可能行动的概率。

4. 价值网络(Value Network):用于预测在给定状态下采取某个策略的预期回报。这有助于评估不同策略的好坏。

5. 经验回放(Experience Replay):一种用于稳定训练过程的技术,它通过存储过去的经验(状态、行动、奖励)并在训练过程中随机抽取来更新网络。

6. 目标网络(Target Network):为了减少训练过程中的不稳定性,DRL算法通常会使用两个相同的网络,一个用于生成目标(Target Network),另一个用于学习(Online Network)。定期更新目标网络,以平滑学习过程。

二、应用领域:

深度强化学习(DRL)作为一种先进的机器学习方法,在多个领域都有广泛的应用。以下是一些典型的DRL应用场景:

1. 游戏领域:DRL在游戏AI领域取得了显著成就,例如AlphaGo利用DRL技术在围棋游戏中战胜了世界冠军。此外,DRL也被应用于其他类型的游戏中,如Atari 2600游戏,ViZDoom和StarCraft II等,以提升算法的通用性和决策能力。

2. 自动驾驶汽车:DRL可以用于自动驾驶汽车中的轨迹优化、运动规划、动态路径规划、控制器优化等任务。例如,AWS DeepRacer使用强化学习模型控制油门和方向,Wayve.ai使用DRL算法训练汽车在复杂环境中驾驶。

3. 工业自动化:在工业领域,DRL被用于优化生产流程,提高效率和降低成本。例如,DeepMind使用DRL来冷却谷歌数据中心,减少了能源支出。

4. 金融交易:DRL在金融领域中用于预测股票价格和决定买卖时机,提高交易效率和盈利能力。

5. 自然语言处理(NLP):DRL在NLP中可以用于文本摘要、问答系统和机器翻译等任务,提高语言模型的性能。

6. 医疗保健:DRL在医疗领域中可以用于患者治疗策略的优化,例如慢性病管理和重症监护。

7. 机器人操作:DRL可以用于机器人的控制和操作,提高机器人执行复杂任务的能力。

8. 推荐系统:在推荐系统中,DRL可以根据用户的动态偏好实时调整推荐策略,提高推荐的准确性和用户满意度。

这些应用场景展示了DRL技术在不同领域的潜力和影响力。随着技术的进一步发展,DRL预计将在更多领域发挥重要作用。

三、常见算法:

深度强化学习(DRL)领域中,存在多种算法,它们各自具有不同的特点和适用场景。以下是一些常见的DRL算法:

1. Deep Q-Network (DQN):DQN算法将Q-Learning与深度学习结合,使用神经网络来近似动作价值函数(Q-function),并引入经验回放和目标网络来提高学习稳定性。

2. Double DQN:作为DQN的改进版,Double DQN使用两个神经网络来减少估计中的偏差,一个用于选择最佳动作,另一个用于评估这个选择。

3. Dueling DQN:Dueling DQN改进了DQN的结构,将状态值函数和动作优势函数分开估计,以提高学习效率。

4. Deep Recurrent Q-Network (DRQN):DRQN将循环神经网络(RNN)引入DQN,使模型能够处理序列数据和具有时间依赖性的问题。

5. Prioritized Experience Replay:这是一种经验回放机制,它根据样本的重要性对它们进行优先级排序,从而提高学习效率。

6. Asynchronous Advantage Actor-Critic (A3C):A3C算法使用多个并行的Actor-Critic网络来提高数据的采样效率。

7. Trust Region Policy Optimization (TRPO):TRPO算法通过限制策略更新的步长来保证策略的更新是朝着改善方向的,从而提高训练的稳定性。

8. Proximal Policy Optimization (PPO):PPO是TRPO的改进版本,它使用更简单的方法来限制策略更新的步长,以保持训练过程的稳定性。

9. Soft Actor-Critic (SAC):SAC算法使用Softmax策略来选择动作,并通过两个神经网络来近似价值函数和策略函数,适用于连续动作空间。

10. Deep Deterministic Policy Gradient (DDPG):DDPG算法结合了Actor-Critic框架和确定性策略,适用于连续动作空间,使用神经网络来近似动作价值函数和策略。

这些算法在不同的任务和领域中都有广泛的应用,例如游戏、机器人控制、自动驾驶汽车等。选择哪种算法通常取决于具体任务的特点,如动作空间的类型(离散或连续)、任务的复杂性以及所需的训练效率等。

四、优缺点

优点:

1. 处理复杂环境:DRL可以处理高维、非线性的状态和动作空间,适用于复杂的决策问题。

2. 自适应学习能力:DRL能够自适应地学习最优策略,不需要人为设计特征或规则。

3. 端到端学习:DRL是一种端到端的感知与控制系统,具有很强的通用性,可以从原始输入到输出实现直接控制。

4. 迁移学习:DRL可以在不同的任务和环境中进行迁移学习,提高学习效率。

5. 感知与决策结合:深度学习提供了强大的感知能力,而强化学习提供了决策能力,两者结合能够解决复杂系统的感知决策问题。

缺点:

1. 数据和计算资源需求:DRL需要大量的数据和计算资源来训练,训练时间较长。

2. 过拟合风险:DRL可能会出现过拟合问题,需要进行合适的正则化和优化。

3. 学习效率与稳定性:对于复杂任务,DRL可能存在学习效率低和性能不稳定的问题。

4. 探索效率:无模型的DRL依赖于大量的探索,而现实应用场景中奖励可能很稀疏,导致智能体需要进行大量无意义的探索。

5. 泛化能力:DRL算法在现实世界动态、开放和不确定的环境中的泛化能力可能不足。

6. 奖励设计:DRL奖励值的设置没有一个固定的标准,更多的是靠经验,如何有效地设置奖励函数是一项挑战。

为了解决这些问题,研究者们提出了一些方法,如优化算法、正则化技术、算法改进、经验回放以及多任务学习等策略。

五、软件工具

深度强化学习(DRL)的软件工具很多,它们可以帮助研究者和开发者在各种应用场景中实现和测试DRL算法。

1. Reinforcement Learning Toolbox :MATLAB提供的强化学习工具箱,支持使用DQN、PPO、SAC和DDPG等算法进行策略训练,可以与深度学习框架集成,支持在多CPU、GPU上并行运行仿真。

2. Deep Reinforcement Learning (DeepRL) :一个开源项目,提供了多种深度强化学习算法的实现,适合研究者和学习者进行学习和实验。

3. DeepRLHub :一个开源社区和学术组织,提供了多种深度强化学习资源和工具,支持共享和协作。

4. MATLAB & Simulink :提供了深度强化学习解决方案,可以训练神经网络以学习复杂行为,支持从仿真系统或物理系统动态生成数据。

5. AutoPentest-DRL :一个使用深度强化学习技术的自动渗透测试框架,可以确定网络攻击路径并执行模拟攻击。

这些工具覆盖了从理论研究到实际应用的各个方面,为用户提供了强大的支持来开发和部署深度强化学习解决方案。

DRL是一个快速发展的领域,它在许多复杂任务中展现出了巨大的潜力。随着计算能力的提升和算法的改进,DRL在各个领域的应用将会越来越多。