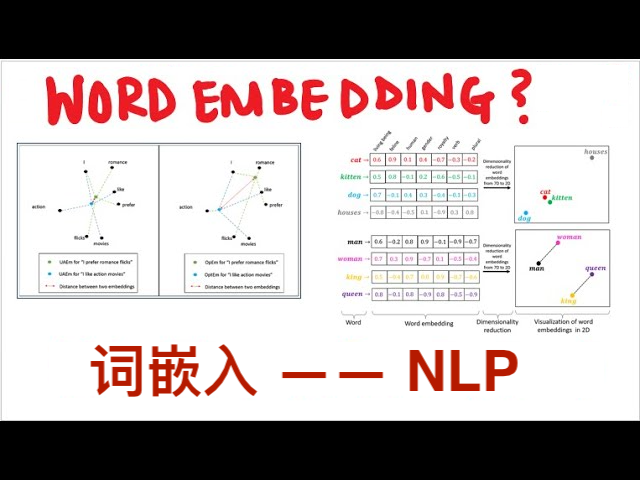

自然语言处理 ❉ 词嵌入(Word Embeddings)

词嵌入是一种在自然语言处理(NLP)中用来表示单词的技术,它将每个单词或短语转换成一个固定长度的密集向量。这些向量能够捕捉到单词的语义信息,即单词的上下文含义和它们之间的关系。使用预训练的词向量可以大大加快模型的训练速度,并提高模型的性能,因为这些词向量已经在大规模的语料库上进行了训练,从而学习到了丰富的语言模式。推动了NLP领域中词义消歧、文本分类、情感分析、机器翻译等任务的性能。

一、词嵌入的类型

1. **One-hot Encoding(独热编码)**:这是最简单的词表示方法,将每个单词表示为一个非常大的向量,向量中只有一个位置是1,其余位置都是0。这种方法的缺点是它没有捕捉到单词之间的任何关系。

2. **Word2Vec**:由Google开发的一种技术,它使用浅层神经网络模型来学习单词的向量表示。Word2Vec有两种架构:连续词袋(CBOW)和跳跃式模型(Skip-Gram)。

3. **GloVe(Global Vectors for Word Representation)**:这是一种基于单词共现统计信息的无监督学习算法,它将单词转换为向量,使得语义上相似的单词在向量空间中彼此接近。

4. **BERT(Bidirectional Encoder Representations from Transformers)**:这是一种基于Transformer架构的预训练语言表示模型,它通过双向上下文来捕捉单词的语义信息。

二、使用预训练词向量的优势

- **效率**:预训练的词向量可以在不同的任务和模型中重复使用,无需每次都从头开始训练。

- **性能**:由于预训练的词向量是在大规模数据集上训练的,它们通常比从零开始训练的词向量具有更好的语义质量。

- **可扩展性**:预训练词向量可以处理词汇表外的单词,对于处理大量词汇的语料库特别有用。

三、如何使用预训练词向量

1. **加载预训练模型**:许多NLP库,如NLTK、spaCy和Hugging Face的Transformers,提供了加载预训练词向量模型的功能。

2. **查找单词的向量表示**:一旦加载了模型,就可以通过模型的API查找特定单词的向量表示。

3. **应用到下游任务**:使用这些向量作为输入特征,可以应用于各种NLP任务,如文本分类、情感分析、机器翻译等。

四、注意事项

- **上下文依赖性**:预训练的词向量可能不总是能够完全捕捉特定上下文中的语义变化。

- **领域适应性**:在特定领域(如医疗、法律)中,可能需要使用特定领域的语料库来训练或调整词向量,以获得更好的性能。

五、发展历史

词嵌入技术发展经历了多个阶段,以下介绍每个阶段的主要内容,帮助读助抓住技术发展方向。

1. **早期模型**:最初的词嵌入技术包括One-hot编码,这是一种简单的表示方法,将每个单词表示为一个非常大的向量,向量中只有一个位置是1,其余位置都是0。

2. **统计模型**:随后发展起来的是基于统计的语言模型,如TF-IDF和n-gram模型,它们考虑了词频和词序信息,但依然存在数据稀疏和维度灾难的问题。

3. **共现矩阵**:共现矩阵是另一种早期的词嵌入方法,通过统计单词在语料库中的共现频率来构建词之间的关系,但这种方法计算成本高且难以处理大量词汇。

4. **Word2Vec**:由Tomas Mikolov等人提出的Word2Vec是词嵌入技术的一个突破,它使用浅层神经网络模型来学习单词的向量表示,包括CBOW和Skip-Gram两种架构。

5. **GloVe**:GloVe(Global Vectors for Word Representation)由Jeffrey Pennington等人提出,它通过矩阵分解技术来学习单词的向量表示,保留了共现矩阵的全局统计信息。

6. **神经概率语言模型**:NNLM(Neural Network Language Model)是另一种早期的神经网络模型,它为后续的词嵌入技术打下了基础。

7. **ELMo**:ELMo(Embeddings from Language Models)是一种深层双向语言模型,它使用LSTM网络来生成每个单词的上下文相关嵌入。

8. **Transformer和BERT**:Transformer模型和其变种BERT(Bidirectional Encoder Representations from Transformers)进一步推动了词嵌入技术的发展,它们通过自注意力机制捕获了单词之间的复杂关系。

9. **多注意力头(Multi-headed Attention)**:Transformer模型中的多注意力头机制允许模型同时关注输入的不同部分,进一步提升了模型的性能。

10. **位置编码和残差连接**:位置编码和残差连接是Transformer模型中的关键技术,它们帮助模型更好地理解单词顺序并提高了模型的稳定性。

使用预训练的词向量是NLP领域的一个重要进展,它极大地推动了各种语言理解和生成任务的发展。