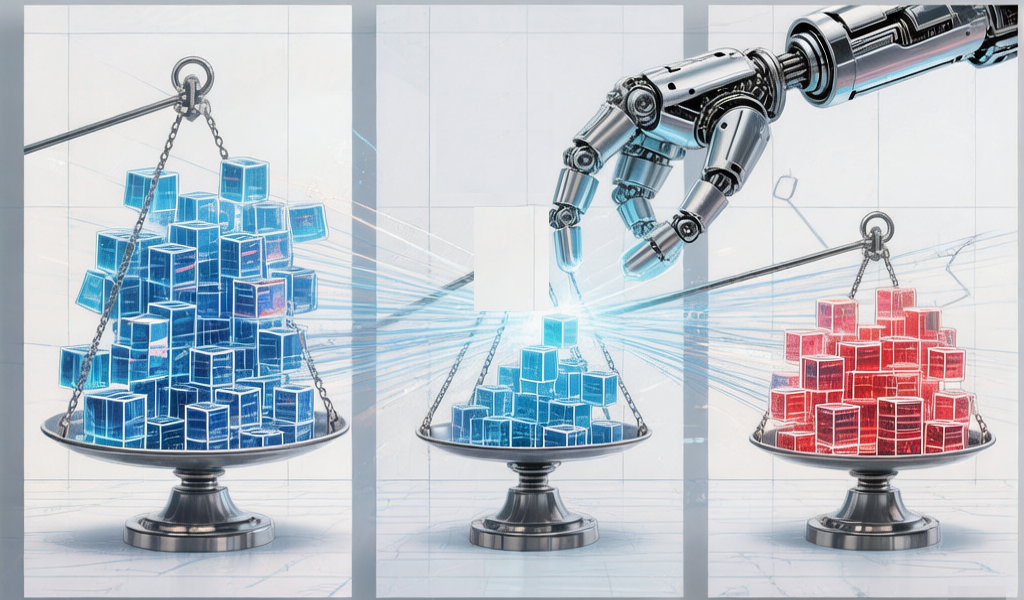

在因果分析中,核心目标是剥离混杂因素的干扰,精准识别“处理”(如政策干预、药物治疗、变量干预)与“结果”之间的真实因果关系。但观测性研究中,处理组(接受干预)与对照组(未接受干预)的样本往往存在系统性差异——即混杂变量(如年龄、性别、基础条件)在两组中的分布不均衡,这种“选择偏差”会导致因果效应估计出现偏差,甚至得出错误结论。匹配方法作为解决该问题的核心样本均衡技巧,通过特定规则为处理组个体匹配条件相似的对照组个体,使两组样本在混杂变量上趋于一致,从而逼近随机对照试验(RCT)的理想场景,其中倾向得分匹配(PSM)与精确匹配是最常用、最具代表性的两种方法。

一、样本均衡为何是因果分析的关键

因果推断的核心逻辑是“反事实框架”:要评估处理的效应,需对比“同一主体接受处理”与“同一主体未接受处理”的结果差异,但现实中无法同时观测这两种状态,只能通过对照组替代“反事实”。此时,若对照组与处理组在混杂变量上分布不均衡,对照组就无法有效替代处理组的“反事实”状态——例如,评估某培训对收入的影响时,若处理组(参加培训)多为高学历人群,对照组(未参加培训)多为低学历人群,直接对比两组收入,会误将学历差异带来的收入差距归因于培训效果。

样本均衡的核心目标,是让处理组与对照组在所有可能影响“处理分配”(是否接受干预)和“结果变量”(干预后的效果)的混杂变量上,分布趋于一致(即“协变量平衡”)。此时,两组的结果差异可近似归因于处理本身,而非混杂因素,从而提升因果效应估计的准确性和可靠性。协变量平衡不仅要求单个协变量在两组中的均值、方差相近,理想情况下还需实现联合分布平衡,即多维度协变量的组合分布一致,这也是匹配方法的核心追求方向。

二、倾向得分匹配(PSM)

(一)原理

倾向得分匹配(Propensity Score Matching, PSM)由Rosenbaum和Rubin于1983年提出,其核心创新是将“多维混杂变量”压缩为“一维倾向得分”,解决了高维协变量难以直接匹配的问题。倾向得分(Propensity Score, PS)是指给定一组协变量的情况下,某一个体接受处理的条件概率,即,其中为处理分配变量(1=接受处理,0=未接受处理),为个体的协变量集合。

PSM的核心假设的是“条件独立假设”(也称为“可忽略性假设”)和“共同支撑假设”:前者指给定倾向得分后,处理分配与潜在结果相互独立(即控制倾向得分后,协变量不再影响处理分配,两组样本可视为随机分配);后者指处理组与对照组的倾向得分存在重叠区域(),确保每个处理组个体都能找到对应的对照组个体,若存在倾向得分超出重叠区域的个体,需予以剔除,否则会影响匹配质量。

简言之,PSM不要求处理组与对照组在每个协变量上完全一致,只需在“倾向得分”这一综合指标上相近,即可认为两组样本的协变量分布整体均衡,进而通过匹配估计因果效应。理论上,基于倾向得分的匹配或加权应能实现协变量平衡,但实践中需通过实证检验确认,不能单纯依赖理论假设,这也是避免“倾向得分同义反复”的关键——即“好的倾向得分能实现平衡,而倾向得分的好坏需通过平衡效果验证”。

(二)操作步骤

PSM的操作流程清晰,核心分为5步,每一步均需兼顾严谨性与实用性,直接影响样本均衡效果和因果推断质量:

1.明确处理组、对照组与协变量:首先界定处理(如政策干预、药物使用),划分处理组与对照组;随后筛选协变量,需选择“预处理变量”(处理发生前已存在的变量),且需同时与处理分配和结果变量相关(即混杂变量),避免遗漏关键协变量(导致残留偏差)或纳入无关变量(稀释倾向得分解释力)。

2.估计倾向得分:通常采用Logistic回归模型(二分类因变量适配性更强),以处理分配变量()为因变量,筛选出的协变量为自变量,估计每个个体的倾向得分。部分场景也可使用Probit模型,模型拟合后需进行诊断(如ROC曲线、Hosmer-Lemeshow检验),确保倾向得分估计的可靠性。

3.选择匹配策略:根据数据特征和研究需求选择合适的匹配方式,常用类型包括:

○最近邻匹配:为每个处理组个体匹配倾向得分最接近的1个或多个对照组个体,操作简单、直观,但可能存在匹配质量不稳定的问题;

○半径匹配:设定固定半径(如0.05),匹配倾向得分落在该半径范围内的所有对照组个体,可保证匹配的相近性,但半径过严可能导致样本损失;

○核匹配:不进行一对一/一对多匹配,而是为每个处理组个体分配权重(权重与对照组个体的倾向得分距离成反比),利用所有对照组个体的信息,减少样本损失;

○分层匹配:将倾向得分划分为多个区间(分层),在每个区间内保证处理组与对照组的样本均衡,再在区间内估计因果效应并加权平均。

4.平衡检验:匹配后需检验协变量平衡效果,核心指标是标准化均值差(SMD),通常认为SMD绝对值<0.1时,协变量平衡效果良好;同时可通过t检验、卡方检验,对比匹配前后协变量在两组中的差异,若匹配后差异不显著,说明样本达到均衡。此外,还可通过倾向得分密度图,观察匹配后两组倾向得分的分布重叠情况。

5.估计因果效应:基于匹配后的均衡样本,计算处理组的平均处理效应(ATT)——即处理组个体接受处理后的结果与匹配对照组结果的差异,这也是PSM最常用的因果效应指标。

(三)优势

1.解决高维协变量匹配难题,将多维信息压缩为一维,降低匹配复杂度;

2.适用范围广,可用于经济学、医学、社会学等多个领域的观测性研究,能突破随机对照试验在伦理、成本上的限制;

3.匹配逻辑灵活,可根据样本量和数据特征选择不同匹配策略,兼顾样本量与均衡效果。

(四)局限性

1.仅能控制可观测的混杂变量,无法处理不可观测混杂变量(如个体动机、潜在能力)带来的“隐性偏差”;

2.依赖倾向得分的估计质量,若协变量筛选不当、模型设定错误(如遗漏交互项),会导致倾向得分估计偏差,进而影响匹配效果;

3.共同支撑假设可能无法满足,导致部分个体无法匹配而被剔除,影响样本代表性和有效样本量;

4.对样本量有一定要求,样本量过小时,难以找到倾向得分相近的匹配个体,匹配质量会显著下降。

三、精确匹配

(一)核心原理

精确匹配(Exact Matching)是最直观、最严格的匹配方法,其核心逻辑是:为每个处理组个体,匹配“所有关键混杂变量取值完全相同”的对照组个体。也就是说,对于选定的每一个混杂变量(如年龄、性别、学历),处理组个体与匹配的对照组个体在该变量上的取值必须完全一致,确保两组个体在关键混杂因素上完全同质,从而彻底消除这些混杂变量带来的偏差。

与PSM的“近似均衡”不同,精确匹配追求的是“完全均衡”——匹配完成后,处理组与对照组在选定的混杂变量上的分布完全一致,不存在任何系统性差异。这种方法的核心优势的是逻辑简单、可解释性强,无需进行复杂的模型估计,仅通过变量取值的完全对应即可实现样本均衡,尤其适用于混杂变量数量较少、且多为分类变量的场景。其本质是通过严格的变量对等,模拟随机分配中“个体同质”的理想状态,从而准确分离处理效应。

(二)核心操作要点

1.筛选关键混杂变量:精确匹配的关键是确定“需完全匹配的混杂变量”,变量选择需遵循“少而精”的原则——若混杂变量过多,会导致“匹配难度激增”,甚至无法找到完全匹配的个体(即“维度灾难”)。通常选择对处理分配和结果变量影响最显著的2-3个核心混杂变量(如医学研究中的性别、年龄分组、基础疾病;社会学研究中的性别、学历、地区)。

2.确定匹配比例:可采用一对一匹配(1个处理组个体匹配1个对照组个体)、一对多匹配(1个处理组个体匹配多个对照组个体,需保证对照组个体均与处理组个体完全同质),或多对一匹配,具体根据对照组样本量确定——对照组样本量充足时,可采用一对多匹配,提升样本利用率;对照组样本量较小时,优先采用一对一匹配,确保匹配成功率。

3.执行匹配与样本筛选:按选定的混杂变量分组,将处理组个体与同组内的对照组个体进行匹配;对于无法找到完全匹配个体的处理组个体,需予以剔除(无法实现反事实替代);对于未被匹配的对照组个体,可根据研究需求选择保留(用于后续稳健性检验)或剔除。匹配过程可通过哈希匹配、精确查询等算法实现,提升匹配效率。

4.验证匹配效果:由于精确匹配要求协变量完全对等,匹配后无需进行复杂的平衡检验,仅需核对两组个体在匹配变量上的取值是否完全一致即可;若存在取值不一致的个体,需重新检查匹配过程,剔除匹配失误的样本。同时,可简单对比匹配后两组的结果变量分布,初步判断匹配的有效性。

(三)优势

1.逻辑简单、直观,可解释性强,无需估计复杂模型,匹配结果易于理解和验证;

2.能彻底消除选定混杂变量带来的偏差,样本均衡效果更彻底,因果效应估计更可靠;

3.操作门槛低,无需掌握复杂的统计模型,适用于初学者或小样本、少混杂变量的场景;

4.匹配过程可重复,给定相同的数据集和匹配规则,重复操作可得到相同的匹配结果。

(四)局限性

1.抗“维度灾难”能力弱,混杂变量过多或存在连续型混杂变量(如收入、年龄连续值)时,难以找到完全匹配的个体,甚至导致匹配失败;

2.样本损失严重,尤其是小样本研究中,大量处理组个体可能因无法找到匹配对象而被剔除,影响样本代表性和统计效力;

3.仅能控制选定的混杂变量,若遗漏关键混杂变量,仍会存在选择偏差,且无法控制不可观测混杂变量;

4.不适用于连续型混杂变量,需对连续变量进行分组(如将年龄分为“18-30岁”“31-40岁”),分组过程可能丢失信息,引入新的偏差。

四、PSM与精确匹配的对比与适用场景选择

两种匹配方法的核心目标一致(实现样本均衡、剥离混杂偏差),但在匹配逻辑、操作难度、适用场景上差异显著,具体对比如下:

从匹配逻辑来看,倾向得分匹配(PSM)是将多维协变量压缩为一维倾向得分,进行近似匹配,而精确匹配则要求关键协变量完全对等,实行严格匹配;在协变量要求上,PSM可处理高维协变量,同时支持连续型、分类型协变量,精确匹配则仅适用于少维协变量,且优先适配分类型协变量;样本损失方面,PSM相对较少,仅需剔除无共同支撑的个体,精确匹配的样本损失则相对较多,所有无法找到完全匹配个体的均需剔除;操作难度上,PSM较高,需要估计倾向得分、选择匹配策略并进行平衡检验,精确匹配则较低,仅需确定匹配变量并执行完全匹配即可;偏差控制层面,PSM可控制可观测混杂变量,但可能存在残留偏差,精确匹配能彻底控制选定混杂变量,不过若遗漏关键变量则易导致偏差;适用场景上,PSM适用于高维协变量、大样本的观测性研究(如政策评估、企业研究),精确匹配则适用于少维协变量、小样本且需严格控制核心混杂变量的场景(如医学小样本试验、精准对比研究)。

场景选择核心原则:

1.若混杂变量较多(≥3个)或存在连续型协变量,优先选择PSM,避免精确匹配的“维度灾难”;

2.若混杂变量较少(≤2个)、且为核心分类变量(如性别、是否患病),优先选择精确匹配,确保混杂变量完全均衡;

3.实际研究中,可结合两种方法使用(如先通过精确匹配控制核心混杂变量,再通过PSM控制剩余协变量),提升因果推断的可靠性。无论选择哪种方法,匹配后都需进行严格的平衡检验,确保样本均衡效果,这是后续因果效应估计的前提。

五、实操关键提醒:提升匹配质量的核心要点

1.协变量选择是基础:无论哪种方法,协变量必须是“预处理变量”(处理发生前已存在),且需同时与处理分配和结果变量相关;避免纳入无关变量,也不可遗漏关键变量,可结合理论知识和数据探索(如相关分析)确定协变量集合。

2.匹配后必须进行平衡检验:PSM需重点检验协变量的标准化均值差(SMD),精确匹配需核对匹配变量的取值一致性;若平衡效果不佳,需重新调整协变量、匹配策略(如PSM更换匹配方法,精确匹配调整匹配变量),不可直接用于因果效应估计。通常认为,标准化均值差绝对值<0.1时,协变量平衡效果满足分析要求。

3.重视样本代表性:匹配后样本需保留足够的有效样本量,避免因样本损失过多导致统计效力不足;对于剔除的个体,需简要说明原因,评估其对研究结论的影响。同时,需确保匹配样本的代表性,避免因过度匹配导致样本失真。

4.规避核心假设违背:PSM需严格满足共同支撑假设和条件独立假设,精确匹配需避免遗漏关键混杂变量;两种方法均无法控制不可观测混杂变量,研究中需在讨论部分说明该局限性,提升研究严谨性。

六、总结

倾向得分匹配(PSM)与精确匹配,是因果分析中解决样本不均衡、剥离混杂偏差的核心技巧,二者均以“协变量平衡”为核心目标,通过匹配构建近似随机的对比样本,从而提升因果效应估计的可靠性。PSM擅长处理高维协变量,灵活性强,适用于大多数观测性研究;精确匹配逻辑简单、均衡效果彻底,适用于少维核心混杂变量的场景。

选择哪种匹配方法,核心取决于混杂变量的数量、类型和样本特征,而非方法本身的“优劣”。实操中,需始终围绕“样本均衡”这一核心,严格遵循匹配流程,重视协变量选择和平衡检验,规避核心假设违背的问题,才能充分发挥匹配方法的价值,精准识别变量间的真实因果关系。同时,需明确两种方法的局限性,尤其是无法控制不可观测混杂变量的问题,在研究设计中尽可能通过多方法验证(如结合双重差分DID),提升研究结论的稳健性。