Q学习(Q-Learning)是一种强化学习算法,它属于无模型预测算法,用于解决马尔可夫决策过程(MDP)问题。Q学习算法的核心思想是通过学习一个动作价值函数(Q函数),来评估在给定状态下采取某个动作的期望效用。

一、基本概念

1. **状态(State)**:环境的某个特定情况或配置。

2. **动作(Action)**:在给定状态下可以采取的可能行为。

3. **奖励(Reward)**:采取某个动作后从环境中获得的即时回报。

4. **策略(Policy)**:从状态到动作的映射,指导如何根据当前状态选择动作。

5. **Q函数(Q-value)**:表示在状态s下采取动作a的期望回报。

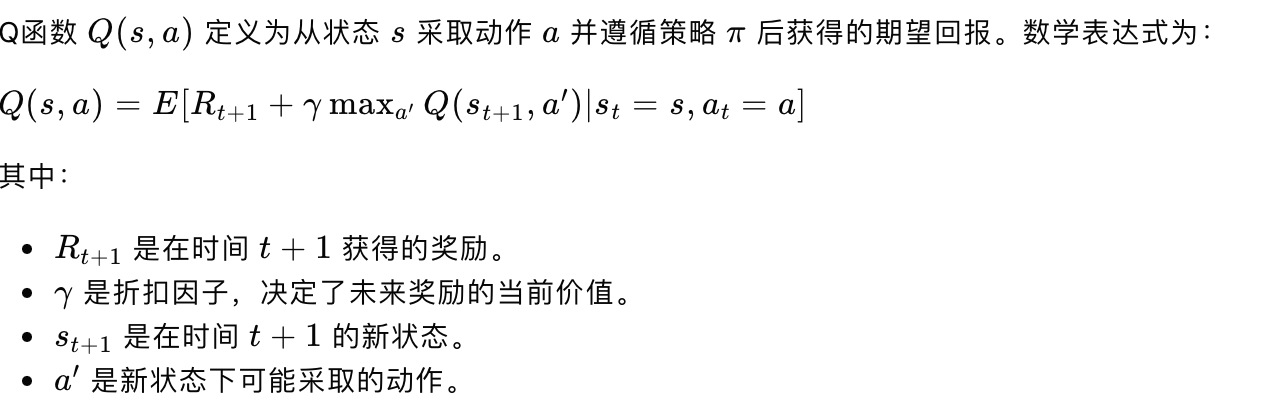

二、Q函数定义

【Q学习定义】

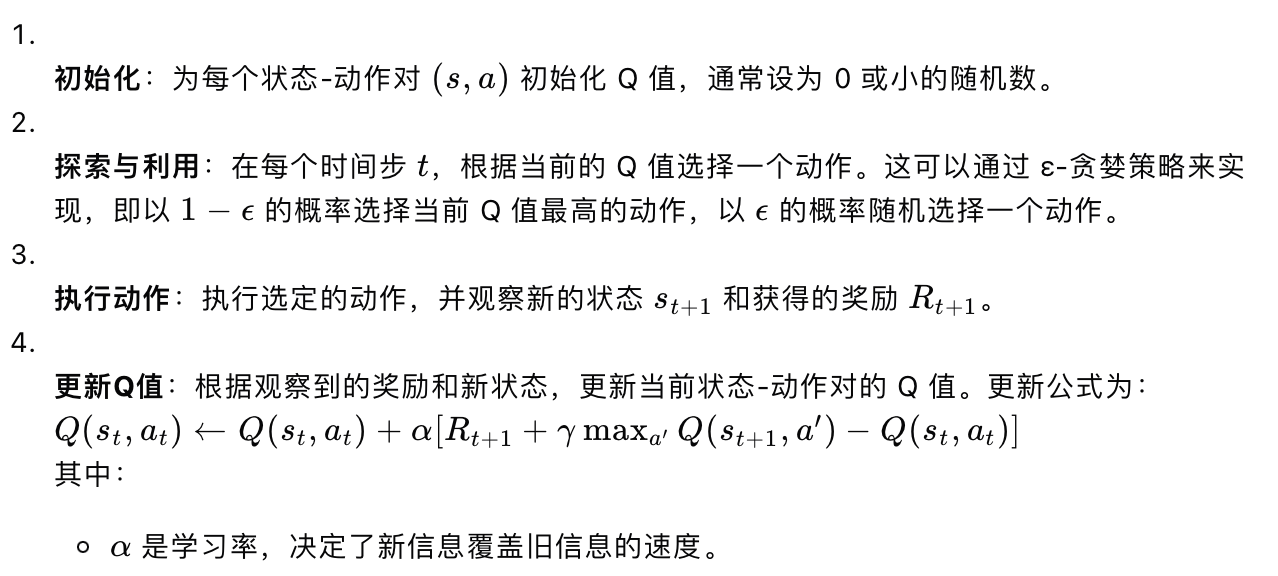

三、Q学习算法步骤

【Q学习步骤】

5. **重复**:重复步骤 2-4,直到满足终止条件,如达到最大迭代次数或 Q 值收敛。

四、特点

- **无需模型**:Q学习不需要环境的动态模型(即转移概率和奖励分布),它通过与环境的交互来学习。

- **离线学习**:Q学习可以离线进行,即在没有实时环境反馈的情况下,使用已经收集的数据来更新 Q 值。

- **收敛性**:在满足一定条件下(如奖励是有限范围的,策略是探索性的),Q学习能够收敛到最优策略。

五、应用场景

Q学习算法已在多个商业领域找到了应用。

1. **供应链管理**:可以帮助优化库存管理、需求预测和物流规划,通过与环境的交互来调整策略,从而减少成本并提高效率。

2. **金融市场分析**:在金融市场中,可以用于交易策略的优化,通过对市场动态的学习来预测价格走势,并制定买入卖出决策。

3. **自动驾驶汽车**:可以帮助自动驾驶汽车在复杂的交通环境中做出决策,如避开障碍物、选择最佳路线、车道保持、超车、停车等。

4. **能源管理**:在智能电网中,可以用来优化电力分配和需求响应,以实现能源使用的最大化效率。

5. **游戏开发**:Q学习是许多高级游戏AI的基础,它可以使游戏中的非玩家角色(NPC)行为更加自然和具有挑战性。让计算机自动学习如何玩各种游戏,如围棋、象棋、Atari游戏等。

6. **机器人控制**:在制造业中,可以使机器人学会如何更好地完成任务,例如组装零件或搬运物品。帮助机器人在复杂环境中如何找到从起点到终点的最优路径。

7. **个性化推荐系统**:可以用于分析用户行为,为用户提供个性化的内容推荐,如电影、音乐或商品推荐。

8. **健康医疗**:在医疗领域,可以帮助制定个性化的治疗计划,通过分析患者的反应来调整治疗方案。

9. **客户服务**:可以用于训练聊天机器人,使其能够更好地理解客户需求并提供相应的服务。

10. **网络安全**:可以帮助识别和防御网络攻击,通过不断学习来提高安全策略的有效性。

11. **推荐系统**:可以用于开发推荐系统,通过学习用户的行为和偏好来推荐商品或内容。

12. **工业自动化**:可以用于优化生产线的调度和控制,提高生产效率和减少成本。

13. **自然语言处理**:虽然这不是Q学习的主要应用领域,但它也可以用于某些自然语言处理任务,如对话系统或文本生成。

14. **教育和模拟**:用于开发教育软件,帮助学生通过模拟和交互学习复杂的概念。

六、Python应用

在Python中通常会使用如`numpy`进行数值计算,`matplotlib`进行数据可视化,以及`gym`库来创建和使用各种强化学习环境。以下是一个简单的Q学习算法的Python代码示例:

```python

import numpy as np

import matplotlib.pyplot as plt

from gym import make

# 初始化参数

env = make('FrozenLake-v0')

n_episodes = 10000

alpha = 0.8 # 学习率

gamma = 0.95 # 折扣因子

epsilon = 0.1 # 探索率

# 初始化Q表格,默认为0

Q_table = np.zeros((env.observation_space.n, env.action_space.n))

# 训练过程

for episode in range(n_episodes):

state = env.reset()

done = False

while not done:

# 选择动作

if np.random.rand() < epsilon:

action = env.action_space.sample() # 随机探索

else:

action = np.argmax(Q_table[state]) # 贪婪选择

# 执行动作并获取反馈

next_state, reward, done, _ = env.step(action)

# 更新Q值

Q_table[state, action] += alpha * (reward + gamma * np.max(Q_table[next_state]) - Q_table[state, action])

state = next_state

# 绘制Q表格

plt.matshow(Q_table)

plt.colorbar()

plt.show()

```

这段代码演示了如何使用Q学习算法解决一个简单的FrozenLake环境问题,其中智能体需要学习如何在冰面上安全行走以到达目标。代码中包含了初始化参数、Q表格、训练过程以及最终的Q表格可视化。

Q学习是强化学习中非常基础且强大的算法之一,它为更复杂的算法(如深度Q网络,Deep Q-Networks,DQN)提供了理论基础。