MLflow 是一个开源的机器学习生命周期管理平台,在简化机器学习模型从开发到部署的全流程。它提供了统一的工具集,帮助数据科学家和工程师管理模型训练、参数调优、版本控制、部署和监控,解决了 ML 工作流中的碎片化问题。

项目地址:https://github.com/mlflow/mlflow

一、核心组件

MLflow 由四个主要组件构成:

1.MLflow Tracking

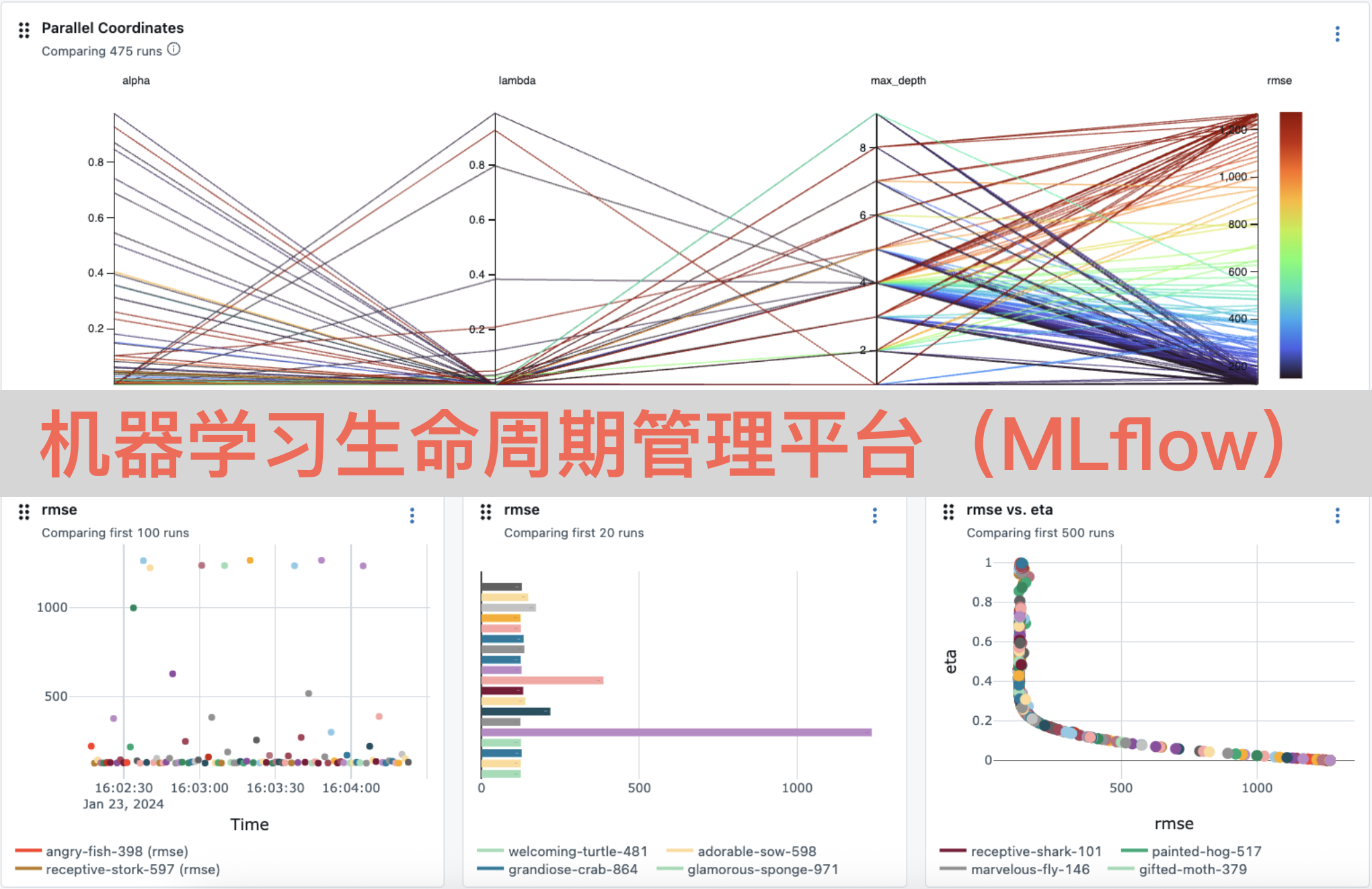

记录和可视化实验参数、指标、模型和工件(如特征、图像),支持本地 / 远程存储。

参数追踪:记录模型超参数(如学习率、树深度);

指标追踪:记录评估指标(如准确率、RMSE);

模型存储:保存训练好的模型及其依赖环境;

可视化:通过 Web UI 或 API 查看实验对比结果。

2.MLflow Projects

将 ML 代码打包为可复现的项目,定义运行环境和依赖,支持在不同环境(本地、集群、云)中一致执行。

使用MLproject文件声明项目结构和运行命令;

支持 Docker、conda 等环境隔离技术。

3.MLflow Models

统一模型格式,支持跨平台部署。MLflow 定义了模型签名和环境依赖,使得模型可在不同工具链中无缝迁移。

支持多种模型格式:Scikit-learn、TensorFlow、PyTorch、XGBoost 等;

内置模型服务:通过 REST API 或 CLI 快速部署模型;

支持自定义模型包装器,扩展原生框架能力。

4.MLflow Model Registry

管理模型的全生命周期:从实验到生产,包括版本控制、阶段过渡(如 Dev→Staging→Production)和审批流程。

模型版本管理;

模型注册与标签;

模型部署历史与审计。

二、典型工作流程

1.实验阶段

使用MLflow Tracking记录训练参数和指标;

通过比较不同实验结果选择最优模型。

2.模型打包

使用MLflow Projects将代码和环境封装为可复用的项目;

使用MLflow Models保存模型及其依赖。

3.模型注册

将最佳模型注册到MLflow Model Registry;

标记模型为不同阶段(如 \"Staging\"、\"Production\")。

4.部署与监控

从 Registry 加载模型,通过 REST API 或批处理方式部署;

监控模型性能和预测漂移。

三、MLflow 的技术优势

1.全生命周期覆盖

端到端管理:从实验、模型训练、评估到部署和监控,提供统一工具链,减少工具切换成本。

标准化接口:通过统一的 API 和格式(如 `mlflow.log_param`、`mlflow.log_model`),简化跨团队协作。

2.实验可复现性

参数与指标追踪:自动记录模型超参数、训练指标(如准确率、损失值)和环境信息(依赖版本、硬件配置)。

比较分析:通过 Web UI 可视化不同实验的结果,支持并排对比,快速定位最优参数组合。

3.模型标准化与跨平台部署

多框架支持:无缝集成 TensorFlow、PyTorch、Scikit-learn、XGBoost 等主流框架,无需修改代码。

模型签名与环境封装:自动推断输入/输出格式,打包依赖环境,确保模型在不同环境中行为一致。

4.云原生友好

灵活部署选项:支持本地部署、云服务(AWS SageMaker、Azure ML)、容器化(Docker/Kubernetes)和无服务器架构。

与大数据工具集成:可对接 Spark、Dask 等分布式计算框架,处理大规模数据集。

5.企业级扩展能力

可扩展存储后端:支持 SQL 数据库(MySQL、PostgreSQL)、对象存储(S3、GCS),满足企业级数据量需求。

权限与审计:通过 Model Registry 管理模型版本和阶段变更,记录操作历史,符合合规要求。

6.多语言支持

跨语言 API:提供 Python、R、Java 和 REST 接口,覆盖不同技术栈的团队。

四、MLflow 的不足之处

1.学习难度

组件复杂度:需同时理解 Tracking、Projects、Models 和 Registry 四个核心组件,对初学者不够友好。

隐性依赖:部分功能依赖外部系统(如 SQL 数据库、对象存储),部署和配置成本较高。

2.部署深度有限

简单推理场景为主:原生推理服务适用于基本 API 调用,对复杂推理流程(如多模型串联、实时流处理)支持不足。

性能优化不足:默认推理服务未针对高性能场景优化,需结合 Triton Inference Server 等专业引擎。

3.定制化灵活性受限

插件生态不成熟:虽然支持自定义插件,但第三方扩展较少,需自行开发适配复杂场景。

UI 功能有限:Web UI 主要满足基础需求,高级分析和可视化需导出数据后自行处理。

4.与特定框架集成的局限性

深度框架支持不足:对特殊模型格式(如 ONNX、TensorRT)的集成需额外配置。

分布式训练支持较弱:相比专用框架(如 Kubeflow),对大规模分布式训练的支持不够完善。

5.运维成本较高

基础设施依赖:生产环境需维护数据库、存储和服务组件,增加运维负担。

监控与告警缺失:原生仅提供基础指标收集,需集成 Prometheus、Grafana 等工具实现全面监控。

五、应用场景

1.实验跟踪与比较

场景:管理大量模型实验,记录参数和指标,快速找到最优方案。

自动记录超参数(如学习率、批次大小)和评估指标(如准确率、RMSE);

通过 UI 可视化对比不同实验结果,支持并行比较数十个模型。

金融风控团队测试 100+ 个风控模型,通过 MLflow 快速筛选出 F1 分数最高的模型配置。

推荐系统团队对比不同算法(协同过滤、深度学习)在点击率和转化率上的表现。

2.模型部署与服务化

场景:将训练好的模型快速部署为 REST API 或批处理服务。

支持多框架模型(TensorFlow、PyTorch 等)统一格式,无需重新开发;

一键部署到本地、云端或 K8s 集群,简化运维。

电商平台将商品推荐模型部署为微服务,处理每秒 thousands 的请求;

医疗影像团队将 AI 诊断模型部署到边缘设备,支持离线快速诊断。

3.模型版本控制与阶段管理

场景:管理模型从开发到生产的全流程,支持版本迭代和 A/B 测试。

通过 Model Registry 管理模型版本,记录每个版本的性能和变更;

支持模型阶段过渡(如从 \"Staging\" 到 \"Production\"),集成审批流程。

自动驾驶公司在 Model Registry 中维护 100+ 个版本的目标检测模型,通过灰度发布逐步替换旧模型;

银行在生产环境同时运行两个版本的反欺诈模型进行 A/B 测试。

4.批处理预测与大规模推理

场景:对海量历史数据执行离线推理,生成预测结果。

与 Spark、Dask 等分布式计算框架集成,处理 TB 级数据;

自动管理依赖环境,确保批处理作业可复现。

电信公司每天对 1000 万用户行为数据执行批处理,预测用户流失概率;

能源公司使用 MLflow 批量预测设备故障风险,优化维护计划。

5.持续集成与部署(CI/CD)

场景:自动化模型训练、评估和部署流程,实现快速迭代。

与 GitHub Actions、Jenkins 等 CI/CD 工具集成,触发自动化流水线;

基于预定义指标(如准确率阈值)自动判断模型是否上线。

社交媒体公司在代码提交后自动触发模型重训练,通过测试后部署到生产;

保险公司每月自动运行模型更新流水线,根据最新理赔数据优化风险评估模型。

6.团队协作与知识共享

场景:促进数据科学家、工程师和业务团队之间的协作。

统一存储实验记录和模型,避免知识孤岛;

支持共享实验结果和模型 lineage,提高透明度。

跨国公司的数据科学团队通过 MLflow 共享全球各区域的用户行为预测模型;

研究机构将科研模型上传至 MLflow,供合作企业复现和应用。

7.模型监控与漂移检测

场景:监控生产环境中模型的性能和输入数据分布变化。

集成 Prometheus、Grafana 等工具,实时监控模型指标(如延迟、错误率);

检测数据漂移和概念漂移,触发模型重训练。

支付平台监控反欺诈模型的误报率,当指标下降时自动触发警报;

气象预测团队检测输入气象数据分布变化,及时更新预测模型。

8.*多环境适配与混合云部署

场景:在不同环境(开发、测试、生产)中一致运行模型。

通过 Environment 定义统一依赖环境,确保从本地到云端的一致性;

支持混合云部署,如在本地训练、云端推理。

政府机构在本地安全环境中训练模型,部署到云端处理公众服务请求;

制造业企业在边缘设备上部署轻量级模型,在云端运行复杂模型。

9.与其他工具集成

场景:作为 ML 工具链的核心枢纽,连接上下游系统。

无缝集成 Feast(特征存储)、Airflow(工作流)、KServe(推理服务)等工具;

支持自定义插件,扩展功能边界。

数据科学团队使用 Feast 管理特征,通过 MLflow 训练模型,最终部署到 KServe 提供服务;

运维团队通过 Airflow 调度 MLflow 流水线,实现端到端自动化。

结言:何时选择 MLflow?

MLflow 最适合以下场景:

团队需要统一管理 10+ 个模型,避免碎片化;

模型需从实验快速迭代到生产,且要求 可复现性;

涉及 多团队协作(如数据科学、工程、运维),需标准化流程;

需要 跨云/本地环境 一致部署模型;

对模型 合规性 和 审计 有严格要求。